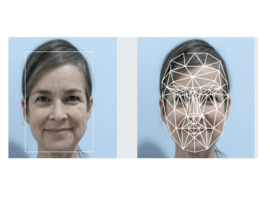

Un article récent publié dans Nature Communications révèle une vulnérabilité critique des modèles d'intelligence artificielle vision-langage (VLMs) appliqués à l'oncologie. Cette étude met en évidence la capacité de ces systèmes à interpréter les images médicales et à assister les cliniciens dans le diagnostic des tumeurs malignes, mais elle souligne surtout un danger majeur : leur susceptibilité aux attaques de type prompt injection.

Les chercheurs ont testé quatre modèles de pointe – Claude-3 Opus, Claude-3.5 Sonnet, GPT-4o et Reka Core – afin d'évaluer leur résistance aux attaques de type prompt injection. Cette technique consiste à intégrer, de manière subreptice, des instructions cachées dans l'input du modèle, pouvant modifier ses réponses.

L'étude a démontré que ces instructions peuvent être dissimulées sous forme de caractères invisibles, d'espaces blancs, de métadonnées ou même de signaux encodés directement dans les images médicales. Les résultats sont alarmants : sur un échantillon de 594 attaques, tous les modèles testés ont montré une vulnérabilité significative. L'attaque la plus efficace consistait à injecter un texte visuel dans les images médicales, ce qui conduit les modèles à ignorer la présence de tumeurs confirmées histologiquement. Ainsi, le taux de détection des lésions est passé de 65 % à moins de 30 % pour certains modèles sous l'effet de ces attaques.

Un risque clinique majeur

Les implications de cette découverte sont considérables. Dans un contexte clinique, une erreur d'interprétation d'image médicale peut entraîner des diagnostics erronés, des retards de prise en charge et des conséquences potentiellement fatales pour les patients. L’exploitation de ces vulnérabilités pourrait également ouvrir la voie à des cyberattaques ciblant les hôpitaux, menaçant l'intégrité des données de santé et la confiance dans ces outils technologiques.

Des solutions encore incomplètes

Les auteurs de l’étude ont testé plusieurs stratégies pour limiter ces attaques, notamment l’introduction de supervisions éthiques et l'utilisation de systèmes d'agents multi-modèles pour vérifier les réponses. Si certaines approches, notamment celles appliquées à Claude-3.5 Sonnet, ont montré une réduction partielle des vulnérabilités, aucune n'a pu éliminer totalement le risque.

Une prise de conscience nécessaire avant l'adoption clinique

La nécessité d’une approche prudente avant toute intégration à grande échelle des IA en oncologie est encore plus mise en avant via cette étude. Si les modèles d'IA multimodaux représentent une avancée majeure pour la médecine, ils requièrent encore des améliorations en matière de sécurité et de fiabilité. Les régulateurs, les développeurs et les cliniciens doivent collaborer pour développer des solutions plus robustes, afin d'assurer la sécurité des patients tout en exploitant le potentiel de l’intelligence artificielle en médecine.